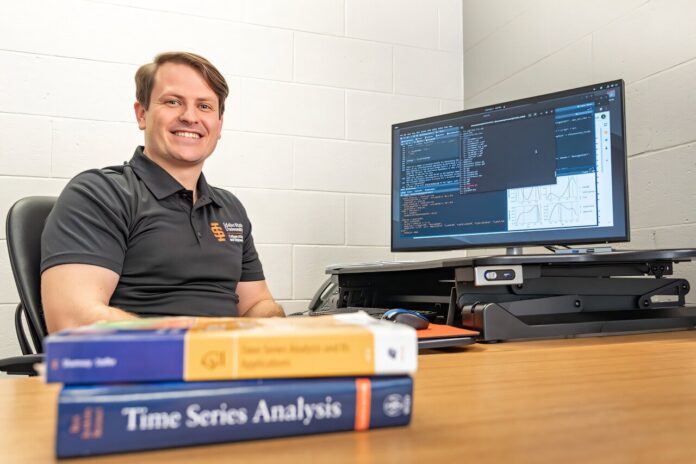

Eine neue Studie weist auf einen potenziellen Fehler in weit verbreiteten Softwaretools hin, die auf einer gängigen statistischen Modellierungstechnik namens ARIMA basieren, was Bedenken hinsichtlich der Genauigkeit von Prognosen in Bereichen von Finanzen bis Ökologie aufkommen lässt. Jesse Wheeler, Assistenzprofessor an der Idaho State University, und sein Co-Autor Edward Ionides haben herausgefunden, dass die Algorithmen, die ARIMA-Modellen in zwei beliebten Softwareumgebungen zugrunde liegen, möglicherweise unzuverlässige Schätzungen liefern, was möglicherweise zu fehlerhaften Vorhersagen und Entscheidungen führt.

ARIMA-Modelle und ihre Bedeutung verstehen

ARIMA-Modelle (Autoregressive Integrated Moving Average) sind ein Eckpfeiler der Zeitreihenanalyse – einer Methode zur Analyse der im Laufe der Zeit gesammelten Daten. Sie funktionieren, indem sie den aktuellen Wert einer Kennzahl – wie den Preis von Eiern oder die Bärenpopulation in einem Wald – mit ihren vergangenen Werten in Beziehung setzen, was es Forschern ermöglicht, Muster und Trends zu erkennen und letztendlich zukünftige Werte vorherzusagen.

Warum ARIMA so verbreitet ist

ARIMA-Modelle sind häufig die erste Zeitreihenmethode, die den Studierenden beigebracht wird, und dienen als Basisvergleich bei der Entwicklung neuer statistischer und maschineller Lernalgorithmen. Ihre Vielseitigkeit hat sie zu unverzichtbaren Werkzeugen in verschiedenen Disziplinen gemacht, darunter:

– Wirtschaft: Prognose von Markttrends und Wirtschaftsindikatoren

– Gesundheitswesen: Analyse von Patientendaten und Vorhersage von Krankheitsausbrüchen

– Wetter: Vorhersage von Temperatur- und Niederschlagsmustern

– Ökologie: Modellierung von Tierpopulationen und Umweltveränderungen

Die Entdeckung: Ein potenzielles Problem bei der Parameterschätzung

Die Forschung von Wheeler und Ionides konzentrierte sich auf einen entscheidenden Aspekt von ARIMA-Modellen: die Parameterschätzung. Parameterschätzungen nutzen gesammelte Stichprobendaten, um auf Merkmale einer größeren Population zu schließen. Die Forscher fanden ein potenzielles Optimierungsproblem innerhalb des Maximum-Likelihood-Schätzalgorithmus – einem Prozess zur Anpassung statistischer Modelle – in der Software, die zur Implementierung von ARIMA-Modellen verwendet wird.

„Das ist so, als hätte man einen Taschenrechner, der behauptet, zwei plus zwei korrekt zu addieren, aber manchmal gibt er ein falsches Ergebnis zurück, etwa zwei plus zwei ergibt drei“, erklärt Wheeler. „Wir verlassen uns oft auf Statistiksoftware wie auf einen Taschenrechner. Wenn der Taschenrechner Ihnen also mitteilt, dass er Ihnen eine bestimmte Parameterschätzung liefert, tun Sie dies besser mit sehr hoher Zuverlässigkeit.“

Der Umfang des Problems

Die Forscher fanden heraus, dass die Maximum-Likelihood-Schätzungen der Software in überraschend vielen Fällen nicht vollständig optimiert waren – je nach Daten und Modell in bis zu 60 % der Fälle. Dies bedeutet, dass den Algorithmen dies trotz des Anspruchs, die Modellwahrscheinlichkeit zu maximieren, häufig nicht gelang. Minderwertige Parameterschätzungen wiederum können die Prognosegenauigkeit und die Zuverlässigkeit anderer statistischer Analysen beeinträchtigen.

Bewältigung des Problems und des weiteren Vorgehens

Entscheidend ist, dass Wheeler und Ionides nicht nur das Problem erkannten; Sie schlugen einen neuen Algorithmus zur Korrektur vor und demonstrierten seine Wirksamkeit mithilfe der Programmiersprache R. Dies bietet eine praktische Lösung für Forscher und Fachleute, die ARIMA-Modelle verwenden.

„ARIMA-Modelle werden täglich von Forschern und Branchenexperten für Prognosen und wissenschaftliche Analysen in vielen Bereichen verwendet … Wenn die Software zur Schätzung dieser Modelle Fehler aufweist, kann dies möglicherweise zu unerwarteten Ergebnissen oder falschen Entscheidungen führen.“

Durch die Behebung dieser Mängel des Maximum-Likelihood-Ansatzes erhöht diese Forschung die Zuverlässigkeit von ARIMA-Modellen und trägt zu einer fundierteren Entscheidungsfindung in einem breiten Spektrum von Bereichen bei, wodurch letztendlich sowohl das wissenschaftliche Verständnis als auch die praktischen Anwendungen verbessert werden. Selbst kleine Verbesserungen der Schätzgenauigkeit können erhebliche Konsequenzen für die Praxis haben